A atual guerra contra Gaza, entrando em nono mês de combates e com mais de 40 mil palestinos mortos, será tragicamente lembrada no futuro por muitos motivos. O número assustador de mortes e ferimentos de civis é apenas um deles. Também entrará para a história por ter sido o primeiro genocídio transmitido ao vivo por meio de nossos telefones, precedido pelo anúncio do ministro da Defesa de Israel, Yoav Galant, de um bloqueio total de água, alimentos, combustível, eletricidade e ajuda humanitária à Faixa, em flagrante violação do Direito Internacional Humanitário (DIH). Também nos lembraremos dessa guerra como aquela em que seu líder, Benjamin Netanyahu, foi recebido com honras no Congresso dos EUA, enquanto enfrentava acusações de genocídio pelo Tribunal Internacional de Justiça das Nações Unidas e um mandado de prisão do Tribunal Penal Internacional.

Mas esse terrível massacre também será estudado por outro motivo muito menos conhecido, mas igualmente alarmante: a ofensiva desencadeada após os ataques de 7 de outubro marca a primeira ocasião em que um exército, o de Israel, incorporou de forma maciça e sistemática o uso de Inteligência Artificial (IA) em suas operações militares, o que desempenhou um papel central na escala sem precedentes de devastação humana e material desse conflito. Um antes e um depois na história militar com profundas implicações legais, éticas e científicas que precisam ser abordadas com urgência pela comunidade internacional.

“Uma fábrica de assassinatos em massa”

Foi assim que um oficial de inteligência israelense descreveu o funcionamento do conjunto de sistemas de IA que o exército israelense está empregando de forma integrada na guerra contra Gaza. Um artigo lançado pela +972 Magazine – um veículo crítico da ocupação formado por jornalistas palestinos e israelenses – publicado no final de novembro do ano passado e que gerou um eco significativo na mídia internacional, embora talvez não tanto quanto se poderia esperar. Um segundo artigo na mesma revista, publicado em abril, completou o quadro da sinistra rede tecnocientífica que sustenta as operações israelenses em Gaza.

Em resumo, a investigação da revista +972 revelou como Israel faz uso integrado de dois sistemas de IA para a geração de alvos militares em Gaza. Por um lado, a IA Habsora (“Evangelho”, em tradução literal) é capaz de identificar edifícios que abrigam membros e agentes militares do Hamas e da Jihad Islâmica Palestina, os dois principais grupos armados que operam em Gaza. Paralelamente, a IA Lavender faz um trabalho semelhante com foco em indivíduos, buscando identificar membros de ambas as organizações. Ambos os sistemas funcionam buscando padrões com base em uma série de elementos fornecidos em uma fase anterior de “treinamento”. O sistema é completado por um terceiro sistema de IA chamado “Where’s Daddy?” (“Onde está papai?”) que rastreia alvos humanos depois que eles são localizados, priorizando o bombardeio de suas casas, pois a probabilidade de um ataque bem-sucedido é considerada muito maior. A designação de alvos militares é sempre acompanhada de estimativas de vítimas civis colaterais do ataque, com uma faixa aceitável estabelecida de 15 para um soldado do Hamas a 300 para um oficial-sênior.

O resultado desse sistema sofisticado é que, nas primeiras semanas da guerra, Israel conseguiu gerar mais de 37 mil alvos militares, em comparação com os 50 por ano que os serviços de inteligência conseguiam gerar anteriormente. Esses alvos militares estão diretamente ligados aos ataques israelenses e ajudam a explicar as impressionantes 15 mil mortes nas primeiras seis semanas do conflito.

As Forças de Defesa de Israel (IDF) não negaram a existência desses sistemas, mas argumentam que eles não determinam seus alvos militares e apenas fornecem informações adicionais aos serviços de inteligência na condução de suas operações. No entanto, vários testemunhos revelaram que, devido à enorme pressão nos estágios iniciais da guerra para atingir o Hamas com a maior força possível, o tempo médio para validação humana do alvo proposto pela Lavender era de cerca de 20 segundos. Na prática, isso passou a significar uma validação quase automática, com apenas uma verificação se o alvo era homem ou mulher, e uma aceitação sistemática no caso de alvos masculinos. A margem de acerto da Lavender é de 90%, o que demonstraria uma autorização sistemática de ataques com o conhecimento de que 10% deles cairiam sobre vítimas civis inocentes.

O problema com a introdução da IA em operações militares não está nos sistemas de IA em si, mas nas atitudes e comportamentos que eles geram. As tecnologias contribuem para moldar as percepções e as ações das pessoas, gerando novas práticas e modos de vida, desempenhando um papel ativo na tomada de decisões e na formação do moral coletivo. No caso em questão, a quase automação da seleção de alvos militares torna rotineiro um ato que tem consequências diretas sobre a vida e a morte de outras pessoas, minimizando a tomada de decisões por parte do pessoal militar. Após décadas de convivência próxima entre máquinas e pessoas, passamos a aceitar como válido o que as máquinas dizem, especialmente nos casos em que elas geram informações em um ritmo rápido demais para que possamos acompanhá-las. A consequência direta disso é a existência de uma aparente “lacuna de responsabilidade”, que cria a ilusão de que as pessoas que validam os alvos militares fornecidos pela IA estão isentas de responsabilidade.

O surgimento de sistemas de IA na arena militar também gerou uma preocupação crescente sobre sua compatibilidade ou não com o Direito Internacional Humanitário (DIH), as leis que regem a guerra. Um número crescente de vozes está pedindo uma estrutura normativa para regular o uso da IA para fins militares a fim de garantir a compatibilidade com o DIH. Outros defendem diretamente sua proibição com base na total incompatibilidade entre a IA e o DIH. Em nível judicial, as consequências do uso desses sistemas sobre a população civil estão no centro dos processos em andamento do governo do primeiro-ministro israelense Benjamin Netanyahu no Tribunal Internacional de Justiça e no Tribunal Penal Internacional.

Israel e tecnologia: uma relação de conveniência

Para entender melhor o quadro no qual os avanços tecnológicos que estão sendo implantados em Gaza pelos militares israelenses ocorreram, vale a pena prestar atenção ao ecossistema de Pesquisa e Desenvolvimento (P&D) de Israel. Atualmente, Israel está em terceiro lugar no mundo em investimentos em IA, atrás apenas dos Estados Unidos e da China. Israel tem o maior número de start-ups per capita do mundo e conta com uma estrutura legislativa que favorece muito sua proliferação. O próprio Netanyahu tem se referido repetidamente à IA como a “nova eletricidade”, afirmando que aqueles que dominarem a IA dominarão o futuro.

Não é coincidência que, em junho de 2023, Sam Altman e Ilya Sutskever, cofundadores da OpenAI, a empresa por trás do ChatGPT, tenham visitado Israel e se encontrado pessoalmente com Netanyahu. Nem que duas das principais empresas de tecnologia do mundo, Intel e NVIDIA, tenham recentemente confirmado dois projetos multimilionários em Israel para a construção de uma fábrica de microchips e um dos mais poderosos supercomputadores até hoje, respectivamente. O Estado israelense favorece ativamente a inovação tecnológica, que acaba revertendo e adaptando às necessidades de seu aparato militar. Tecnologias que Israel vende posteriormente a outras nações, com o incentivo de terem sido comprovadas em combate.

IA e progresso, uma faca de dois gumes

O rápido desenvolvimento da IA nos últimos dez anos e sua incursão cada vez mais difundida em praticamente todas as esferas de nossas sociedades, da medicina às finanças, da criação artística à tradução simultânea, gerou uma preocupação crescente com os efeitos negativos e/ou não-intencionais de muitos desses novos sistemas. Paralelamente ao crescimento da IA, a comunidade acadêmica e de pesquisa liderou uma série de iniciativas que pedem o estabelecimento de uma estrutura comum para o desenvolvimento da IA, ancorada nos princípios e valores éticos e morais das democracias modernas, incluindo os Princípios de Asilomar e a Declaração de Barcelona. Em todas essas iniciativas, encontramos um apelo à necessidade urgente de regulamentar o desenvolvimento da IA para garantir que as necessidades humanas sejam sempre mantidas como centrais, por meio de uma estrutura ética que certifique os desenvolvimentos tecnológicos em IA e uma demanda por transparência e responsabilidade dos sistemas.

É amplamente aceito que a IA tem um enorme potencial para enfrentar os principais desafios contemporâneos, como as mudanças climáticas ou a proliferação de pandemias, mas também que ela representa uma ameaça direta aos direitos humanos básicos. Em seu último relatório anual, a Anistia Internacional alertou pela primeira vez sobre a ameaça do avanço descontrolado da IA e o risco de aumentar as desigualdades raciais, a vigilância e o discurso de ódio na Internet.

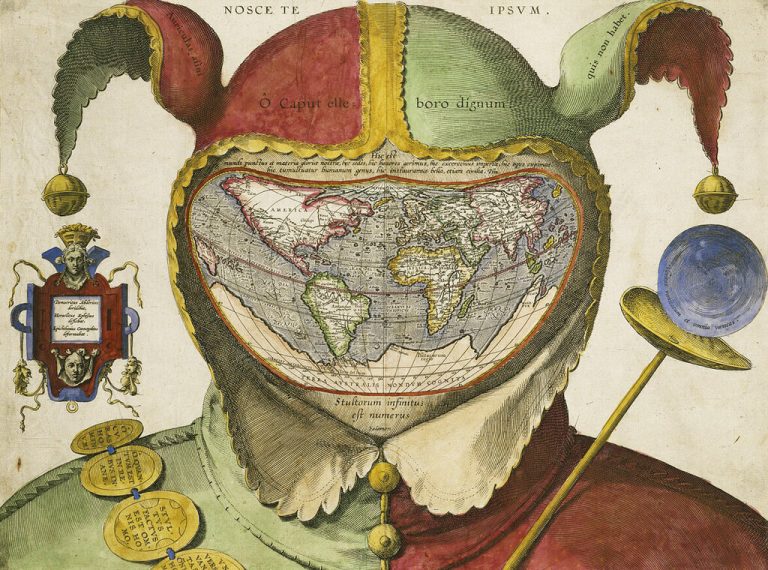

O filósofo português Boaventura de Sousa Santos, em sua brilhante reflexão sobre incerteza, medo e esperança, advertiu como o conhecimento científico e os desenvolvimentos tecnológicos derivados tendem a ser controlados por determinados grupos sociais e a beneficiá-los, deixando o restante da população à margem, de modo que a produção científica é dirigida “sobre eles e, eventualmente, contra eles e, em todo caso, nunca com eles”.

O número devastador de vítimas civis na Faixa de Gaza é, dependendo de como se olha para ele, uma ilustração dramática de como as tecnologias moldam nossas sociedades, mentalidades e comportamentos, e evidencia a necessidade urgente de regulamentar o desenvolvimento de novas tecnologias baseadas em IA. Uma regulamentação que, no entanto, parece distante e até utópica no caso de tecnologias para fins militares, contra as quais as demandas por transparência e livre acesso se chocam frontalmente. Diante desse aparente impasse, uma moratória total sobre o uso de IA para fins militares até que uma regulamentação acordada internacionalmente esteja em vigor parece ser uma solução lógica, mas é improvável que seja aceita pelas principais potências militares.

No mesmo ano em que o texto de Boaventura de Sousa foi publicado, houve um avanço nas técnicas de detecção de câncer de mama por meio da colaboração homem-máquina. Ao combinar os resultados do patologista, que tinha uma margem de erro de 3,4%, e os de um sistema de IA, que tinha uma margem de erro de 7,5%, a margem de erro foi reduzida para apenas 0,52%. O progresso científico melhorou muito a qualidade de vida em alguns aspectos e, sem dúvida, piorou-a em outros. Graças à tecnologia, temos uma vida mais longa e melhor, mas também estamos levando o planeta em que vivemos a limites que podem acabar tornando-o inabitável. Diante desse dilema, o caminho a seguir é que a tecnologia sirva às pessoas e não o contrário, evitando assim que as pessoas passem a ser meios para os fins do progresso.

(*) Tradução de Raul Chiliani